在今年的WWDC大会上,苹果并没有过多地介绍visionOS,从那以后,它就没有受到太多关注。但不要误以为这是毫无意义的。最近发生的两件事表明,幕后发生了很多事情。

首先是《淹没》的上映,这是第一部以沉浸式视频拍摄的电影,由奥斯卡获奖电影制作人爱德华·伯杰(《西线无战事》)编剧和导演。

第二个是苹果机器学习团队的新研究,展示了如何使用传统计算机从单镜头相机中创建准确的景深数据。

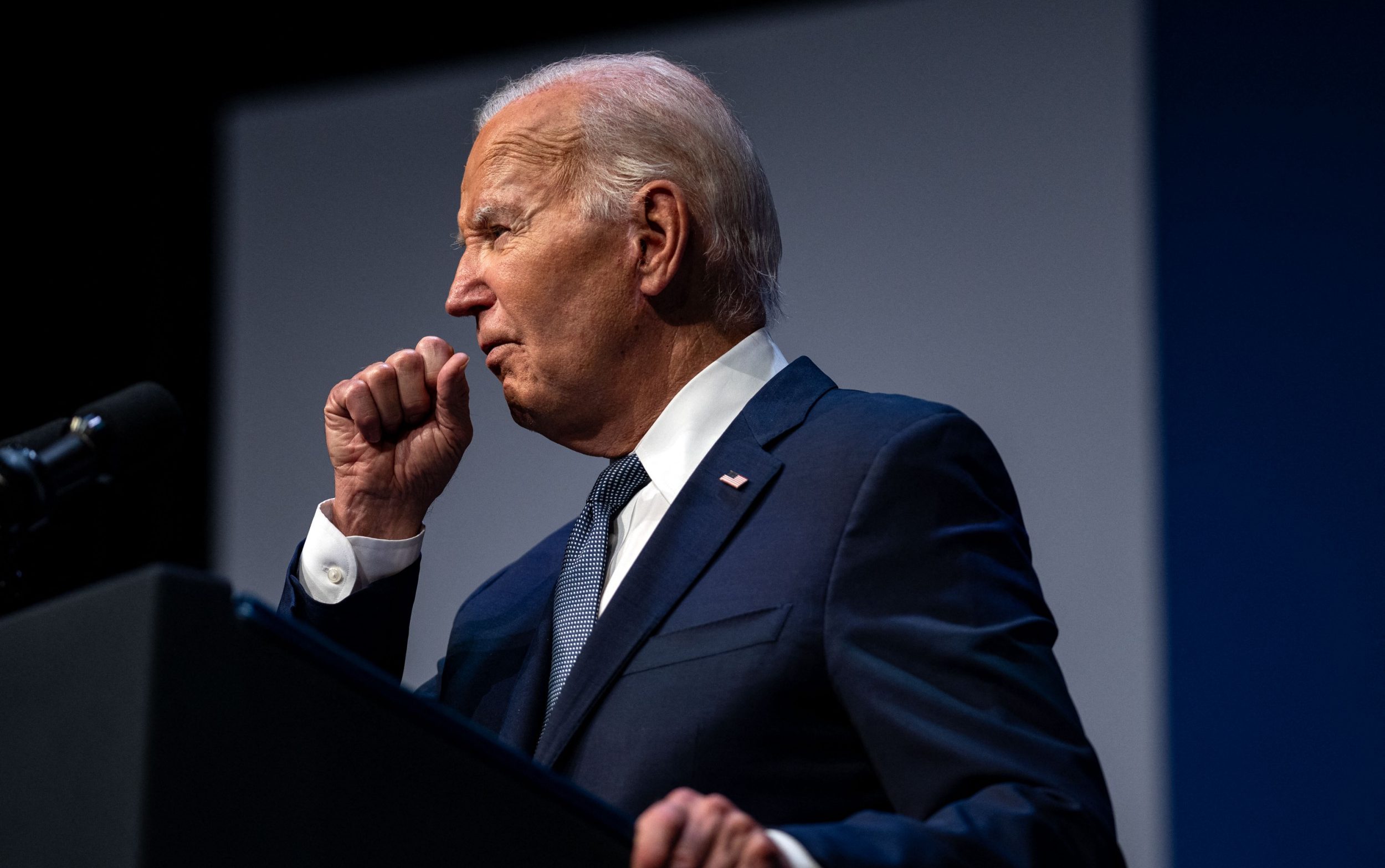

《淹没》是一部幽闭恐怖、刺激肾上腺素分泌的影片,时长17分钟,故事发生在一艘正在沉没的船上——这是一艘被战争破坏的潜艇——船员们为生存而战。这部电影是为Vision Pro设备制作的,评论家们已经表示,它提供了一种他们从未体验过的即时性和亲切感。

所有这些都很有趣,但如何才能以更强大的方式传递这种体验呢?苹果的技术如何支持更加身临其境的用户体验?

这就是我认为苹果正在努力解决的问题,这是基于过去几天出现的第二件事:苹果推出了一款名为Depth Pro的基于人工智能的机型。

它的作用是强大的。AI基本上可以映射2D图像的深度。它背后的技术似乎类似于你在制造一辆自动驾驶汽车时所期望的,因为这种汽车必须能够利用附近物体的图像实时准确地确定深度。

苹果的研究人员似乎已经开发了这项技术,以便它能在iPhone上准确运行。他们声称,使用Depth Pro模型的应用程序在运行标准GPU的计算机上运行时,可以在0.3秒内根据单镜头相机拍摄的图像生成准确的深度图。

该团队表示,这项技术可能对机器人、实时地图以及改进的相机或视频效果产生重大影响。你可以在这里阅读该公司关于这些功能的研究论文,也可以在该公司的机器学习网站上阅读有关Depth Pro的文章。

能够将其带到电影中表明苹果现在拥有一项可以自动从2D图像中计算深度的技术。当然,电影只是一系列2D图像,这意味着该公司有技术根据你在屏幕上看到的内容来确定空间定位。

你已经在某种程度上看到了这一点,因为visionOS可以将现有照片转换为空间图像,增加深度以创建立体效果。使用这项技术从2D图像生成3D环境也是有意义的。

下一个什么?2023年8月,苹果研究人员发表了一篇解释FineRecon的论文,该论文展示了如何使用人工智能从摆拍图像构建3D场景,使其更准确,并提供更逼真的场景。这项研究与早期关于提供增强3D室内场景理解的项目的信息很好地结合在一起。

综合所有这些因素,从理论上讲,苹果可能实现的突破可能包括创造一种既能理解图像,又能添加图像的技术。毕竟,如果你知道对象A在一个位置,而对象B在另一个位置,你就可以更容易地向Vision Pro用户提供在这些对象之间甚至后面行走的错觉。

生成式人工智能(genAI)解决方案已经存在,可以创建“假”视频或图像,但计算机能在多大程度上利用其景深知识来生成3D体验,让你真的可以走在你看到的物体后面?如何将这些技术应用到观看苹果《淹没》电影的观看体验中?

尽管如此,在一艘沉没的潜艇上的体验从两种意义上来说都是身临其境的——但能够在这种行动中以高保真度找到自己的视角,将实现每个电子游戏玩家的梦想。它肯定会卖一些电影。

重要的是不要跳得太远。构建实现这些事情的技术将比简单地在散文中夸夸夸谈的可能性更具挑战性,但是基于2D图像的精确景深数据的应用还有其他潜在的视觉操作系统含义。我特别想在应急响应、医疗、远程无人机控制甚至太空探索方面的应用,所有这些都是通过单镜头相机实现的,这使得这项技术重量轻、便携性高。

换句话说,除了创造性表达的新领域之外,苹果公司自制的现实扭曲机器即将开启可行的商业机会。我们会在明年的WWDC上看到其中的一些公司与visionOS 3.0一起出现吗?到那时,我们就能真正看到苹果智能是如何利用空间现实创造奇迹的吗?

请在linkedIn、Mastodon上关注我,或者加入我在MeWe上的AppleHolic的酒吧和烧烤群。