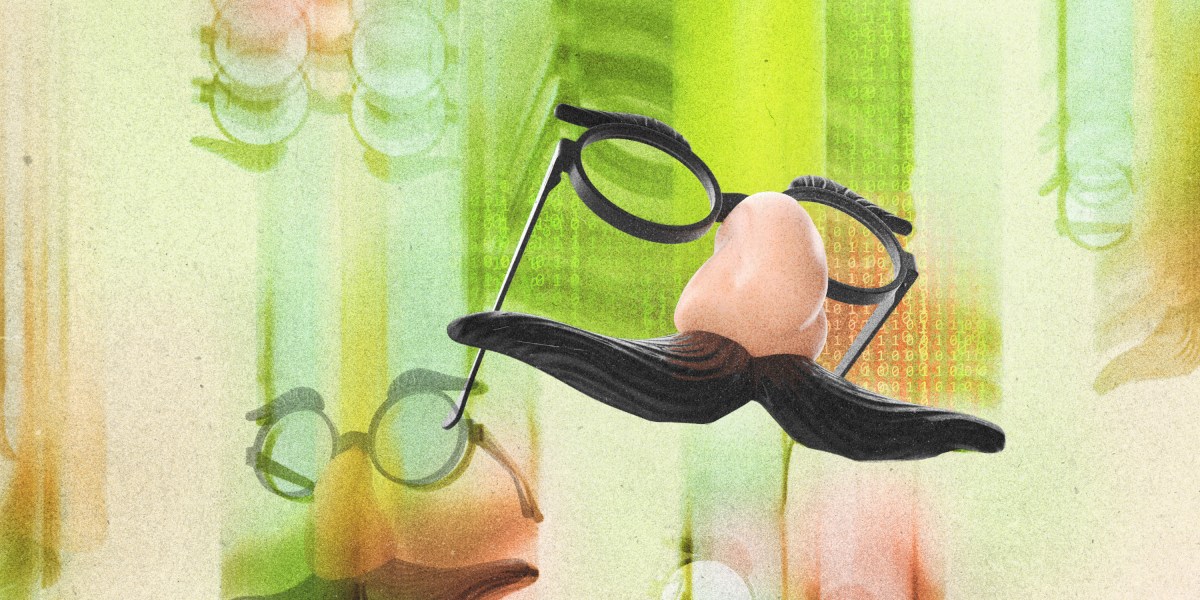

最近,我们看到了一些更大规模的人工智能失败。在最近一次(令人捧腹的)失态中,谷歌的双子座(Gemini)拒绝生成白人,尤其是白人男性的图像。相反,用户可以生成黑人教皇和纳粹女士兵的图像。谷歌一直试图让其模型的输出减少偏见,但这适得其反,这家科技公司很快发现自己陷入了美国文化战争的漩涡中,保守派批评人士和埃隆·马斯克(Elon Musk)指责谷歌存在“清醒的”偏见,没有准确地反映历史。谷歌道歉并暂停了该功能。

在另一起现在很有名的事件中,微软的必应聊天工具让《纽约时报》的一名记者离开他的妻子。客户服务聊天机器人不断给他们的公司带来各种麻烦。例如,加拿大航空公司(Air Canada)最近被迫向一位客户退款,因为该公司的客服聊天机器人制定了一项政策。这样的例子不胜枚举。

科技公司正急于推出人工智能产品,尽管有大量证据表明它们难以控制,而且往往以不可预测的方式行事。这种奇怪的行为之所以会发生,是因为没有人确切知道深度学习是如何工作的,或者为什么深度学习是当今人工智能繁荣背后的基础技术。这是人工智能领域最大的难题之一。我的同事Will Douglas Heaven刚刚发表了一篇文章,他对此进行了深入研究。

最大的谜团是,像Gemini和OpenAI的GPT-4这样的大型语言模型是如何学会做一些它们没有被教过的事情的。你可以用英语训练一个数学问题的语言模型,然后向它展示法国文学,从中,它可以学习用法语解决数学问题。威尔写道,这些能力与经典统计学背道而驰,后者为预测模型的行为提供了最好的解释。点击这里阅读更多内容。

我们很容易把我们的无知误认为是魔法。可悲的是,就连这项技术的名称——人工智能——也具有误导性。语言模型看起来很聪明,因为它们通过预测句子中的下一个单词来生成类似人类的散文。这项技术并不是真正的智能,这样称呼它会微妙地改变我们的期望,所以我们认为这项技术比实际情况更有能力。

不要落入科技行业的营销陷阱,认为这些模型是无所不知的或真实的,甚至接近于我们期望它们做的工作。由于它们的不可预测性、失控的偏差、安全漏洞和编造的倾向,它们的用处极其有限。它们可以帮助人类头脑风暴,它们可以娱乐我们。但是,了解了这些模型的故障和易发生故障后,将您的信用卡详细信息、敏感信息或任何关键用例托付给它们可能不是一个好主意。

正如威尔文章中的科学家所说,人工智能研究领域仍处于早期阶段。哈佛大学(Harvard University)的计算机科学家博阿兹?巴拉克(Boaz Barak)目前被外派到OpenAI的超对齐团队,他表示,该领域的许多人将其与20世纪初爱因斯坦提出相对论的物理学相提并论。

目前该领域的焦点是模型如何产生它们所做的事情,但需要更多的研究来解释它们为什么会这样做。在我们更好地了解人工智能的内部之前,预计会有更多奇怪的错误和大量的炒作,而这项技术将不可避免地无法实现。