这篇文章是Lifehacker“揭露人工智能”系列的一部分。我们正在探索六种不同类型的人工智能生成的媒体,并强调常见的怪癖,副产品和标志,帮助你区分人工和人类创造的内容。

人工智能公司对视频生成器感到兴奋:他们吹捧这些新模型提供的创造性可能性,并津津乐道于最终结果的令人印象深刻。然而,在我看来,一项允许任何人用一个简单的提示来制作逼真视频的技术既不有趣也不有前途,而是可怕的。你真的想生活在一个你在网上看到的任何视频都可能是用人工智能凭空创造出来的世界吗?不管你喜不喜欢,这就是我们要去的地方。

当你给坏人提供了操纵视频的工具,以至于很多人(如果不是大多数人)都会相信这是真的,你就是在火上浇油,而自从第一个人在互联网上撒谎以来,这种火就一直在燃烧。现在比以往任何时候都更重要的是要警惕我们在网上看到的东西,并对任何声称代表现实的视频持批判态度-特别是当现实意在激怒我们或影响我们对世界的看法时。

现在有两种类型的人工智能视频需要关注。第一种是完全由人工智能模型生成的视频,整个序列没有使用真实的镜头,在制作之前从未存在过。想想OpenAI的Sora模型,它能够渲染短而高质量的视频,很容易让人们误以为它们是真实的。幸运的是,Sora还在开发中,还没有向公众开放,但是有其他的工具可以用来从头开始生成这些视频。

在这个时间点上,更相关的,更令人担忧的是短期影响,是人工智能改变的视频。想想深度造假:使用人工智能将一个人的脸覆盖在另一个人的脸上,或者改变一个真实的脸来匹配被操纵的音频内容的真实视频。

我们将介绍发现这两种类型的AI视频内容的方法:随着AI视频生成器变得更好,变得更容易访问,你可能会开始看到这些视频出现在网上,就像AI图像爆炸一样。保持警惕。

与其他生成式AI模型一样,AI视频生成器需要输入大量数据才能工作。人工智能图像模型在单个图像上进行训练,并学习识别静态片段上的模式和关系,人工智能视频生成器被训练来寻找多个图像之间的关系,以及这些图像如何按顺序变化。毕竟,视频只是一系列单独的图像,以一种创造运动幻觉的速度回放。如果你想让一个程序凭空生成视频,你不仅需要它们能够生成这些视频中的主题,还需要知道这些主题应该如何在帧与帧之间变化。

深度造假程序是专门针对人脸进行训练的,旨在模仿它们所叠加视频的动作和情绪。他们经常使用生成对抗网络(GAN),它将两个AI模型相互设置:一个生成AI内容,另一个试图识别该内容是否是AI生成的。另一方面,像Sora这样的模型,从理论上讲,能够生成任何你要求它做的视频。Sora是所谓的扩散模型,它向训练数据中添加“噪声”(实际上是静态的),直到原始图像消失。从这里开始,模型将尝试从噪声中创建一个新版本的数据,这将训练它从头开始创建新内容。

人工智能视频的全面生成仍处于早期阶段,虽然深度造假技术很好,但还不够出色。这些技术的局限性在未来的迭代中可能不会出现,但就今天而言,你可以通过一些线索来判断你正在观看的视频是真实的,还是被操纵的。

将一个人的脸叠加在另一个人的脸上的技术令人印象深刻,但它远非完美。在许多(如果不是大多数)情况下,深度伪造会有明显的伪造迹象。通常情况下,它看起来像一个平庸的ps:脸不会融入人的头部的其他部分,灯光与场景设置不匹配,整个事情都有一个恐怖谷效应。

如果你在看一个名人说或做一些有争议的事情的视频,真的看看他们的脸:人工智能有没有可能在这里发挥作用?这段“奥巴马总统”说荒唐话的视频展示了其中的一些缺陷。这个深度假视频是六年前制作的,但它展示了这种人工智能修改视频的一些明显的视觉缺陷:

同样,当前深度伪造技术的另一个缺陷是,它很难将假脸的嘴部运动与潜在的语音相匹配——尤其是如果语音也是人造的。

看看去年安德森·库珀(Anderson Cooper)的这张深度假脸:假脸比上面奥巴马的视频更逼真,但嘴唇的动作与他们给安德森(AI Anderson)的演讲不符:

社交媒体上流传的许多深度造假作品制作得非常糟糕,如果你知道自己在寻找什么,就会发现它们明显是人工智能的垃圾。很多人都不喜欢,所以他们看到一个政客说了一些他们不喜欢的话的视频,就认为这是真的——或者被逗乐了,根本不在乎。

与人工智能图像生成器一样,人工智能视频生成器也会生成带有奇怪故障和伪影的视频。你可能会注意到,当相机移动到树上的叶子时,树叶在闪烁,或者有人在背景中行走,帧率与视频的其他部分不同。虽然下面的视频第一眼看起来很逼真,但它充满了这些小故障,尤其是在树上。(另外,请注意左边路上的汽车是如何不断消失的。)

但最糟糕的是什么呢?Deepfakes。这些视频通常看起来很可怕,好像它们已经被下载和重新上传了1000次,在这个过程中失去了所有的保真度。这是故意的,试图掩盖视频中的缺陷。如果以4K格式呈现,大多数深度伪造视频都会在瞬间暴露自己,因为高分辨率视频会突出上述所有缺陷。但是当你降低质量时,就更容易隐藏这些缺陷,从而更容易欺骗人们,让他们相信视频是真实的。

摄像机将捕捉世界的真实面貌,至少相机的镜头和传感器能够做到这一点。另一方面,人工智能视频生成器根据之前看到的内容创建视频,但没有任何额外的背景。它实际上什么都不知道,所以它尽可能地填补空白。这可能会导致AI生成视频中的一些不稳定的物理现象。

例如,Sora制作了一段视频,内容是阿马尔菲海岸(Amalfi Coast)悬崖上的一座教堂。乍一看,它看起来很有说服力。然而,如果你把注意力集中在海洋上,你会发现海浪实际上是在远离海岸,朝着相反的方向移动。

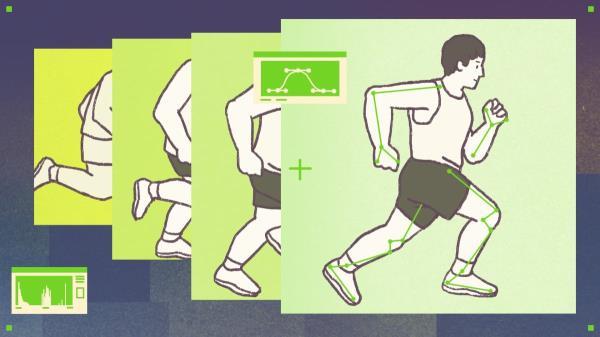

这台发电机还制作了一段令人信服的视频,内容是一名男子在跑步机上跑步。这里最重要的是,这个人在背对跑步机的时候是“向前”跑的,因为这个模型并不完全理解跑步机应该是如何工作的。但仔细观察,你会发现这个男人的步伐并不正常:就好像他的上半身时不时地停下来,而下半身却在继续前进。在现实世界中,这是不可能的,但Sora实际上并不理解跑步物理应该如何工作。

在另一段视频中,“考古学家”在沙漠的沙子中发现了一把塑料椅子,他们把它拉出来,掸掉上面的灰尘。虽然这对模型来说是一个复杂的要求,而且它确实渲染了一些现实的时刻,但与整个努力相关的物理原理是远远不够的:椅子凭空出现,拿着它的人以一种没有人会的方式携带它,椅子最终自己漂浮起来,最终在剪辑结束时完全扭曲成其他东西。

制作这段视频内容的人工智能模型不知道你应该有多少条四肢。他们把肢体在帧之间移动联系起来,但不太明白肢体在整个场景中应该是相同的。

这就是为什么你会在视频中看到手臂、腿和爪子反复出现的原因。虽然这种情况并不总是发生,但你可以在苍井空的这段视频中看到:当“摄像机”跟踪女性向前行走时,有第三只手在她面前摆动,可以看到她的左臂和左侧之间。这很微妙,但这是人工智能视频生成器会做的事情。

在这个例子中,仔细观察这只猫:在视频快结束的时候,它突然长出了第三只爪子,因为模型不明白这种事情在现实世界中通常不会发生。另一方面,当女人在床上翻身时,她的“手臂”似乎变成了床单。

额外的肢体没有多大意义,但在人工智能视频中往往不止如此。同样,这些模型实际上什么都不知道:它们只是试图根据它们所训练的数据集复制提示。例如,他们知道阿马尔菲海岸的一个小镇应该有很多石头楼梯,但他们似乎不明白这些楼梯必须通向某个地方。在OpenAI的演示视频中,许多楼梯都是随意放置的,没有真正的目的地。

在同一段视频中,观察人群中的“人”。起初,它可能看起来像一群游客在城里闲逛,但其中一些游客消失在空气中。有些人看起来像是在往楼下走,但他们并没有走楼梯:他们只是在平地上“往楼下走”。

一段时间以来,对你在网上看到的东西持保留态度是很重要的。你不需要人工智能来撰写扭曲事实的误导性博客文章,或者操纵视频剪辑以你想要的方式构建故事。但人工智能视频是不同的:不仅视频本身是被操纵的,整个事情可能永远不会发生。我们不得不如此愤世嫉俗地对待互联网(以及更广阔的世界),这是一种耻辱,但当一个提示可以从无开始制作整个视频时,我们还有什么其他选择呢?